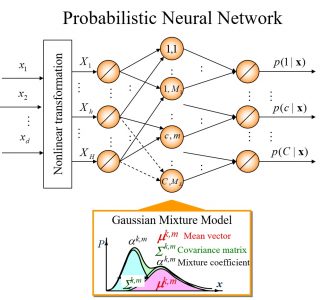

本研究室で提案してきたニューラルネットワークは,確率統計理論に基づく構造をネットワークにあらかじめ内包することで,学習能力の改善と構造決定の容易さを実現してきた.独自に構築したニューラルネットワークには,Log-linearized Gaussian Mixture Network (LLGMN),およびそのリカレントタイプであるReccurent-LLGMN(R-LLGMN)がある.LLGMNは統計モデルの一つである混合正規分布を,R-LLGMNは時系列信号のモデル化に有効なHidden Marcov Model(HMM)を導入したことにそれぞれ相当する.さらに,LLGMNについては,多変量のデータから主成分を抽出して識別を行うReduced-Dimension-LLGMN(RD-LLGMN)や,LLGMNを階層的に構成し効率よくモデル化を行うHierarchical-LLGMN(H-LLGMN)も開発した.LLGMNは時間変化の少ない定常パターンのモデル化に適し,R-LLGMNはダイナミックに時間変化する非定常パターンのモデル化に適する.

研究紹介

新たな確率ニューラルネットワークの提案

関連文献情報

1. A Log-Linearized Gaussian Mixture Network and Its Application to EEG Pattern Classification, T.Tsuji, O.Fukuda, H.Ichinobe and M.Kaneko, IEEE Transactions on Systems, Man, and Cybernetics-Part C: Applications and Reviews, Vol. 29, No. 1, pp.60-72, February, 1999.

2. A Recurrent Log-linearized Gaussian Mixture Network, Toshio Tsuji, Nan Bu, Makoto Kaneko, Osamu Fukuda

IEEE Transactions on Neural Networks, Vol.14, No.2, pp.304-316, March 2003.